Para el análisis de dos variables categóricas nos interesa estudiar cómo se distribuyen los casos según las combinaciones de categorías de cada variable. Por ejemplo, si disponemos de la variable angor y la variable tabaquismo, podemos estudiar cual es la distribución del tabaquismo en el grupo que presenta angor y en aquel que no lo presenta; para todo esto lo ideal es expresarlo mediante una tabla de contingencia donde nos da lo mismo qué variable ocupe las filas y cual las columnas si se trata de variables independientes; para el caso de las variables dependientes una de otra se suele colocar la variable independiente (ejemplo: factor de riesgo) en las filas y la dependiente en columnas.

Tablas de contingencia. Comparación entre variables cualitativas de datos sanitarios con SPSS.

1. Juan Manuel García Torrecillas. Médico de Familia. Servicio de Cuidados Críticos y Urgencias. Complejo Hospitalario Torrecárdenas. Almería.

2. Herminia Moreno Martos. Médico de Familia. Unidad Docente de Medicina Familiar y Comunitaria de Almería.

3. María del Carmen Lea Pereira. FEA en Medicina Interna. EP Hospital de Poniente. El Ejido. Almería.

Es bastante habitual en medicina tener que realizar análisis de variables cualitativas con pocas categorías y dicotómicas. Variables como el sexo, tratamientos, etc. son variables que se comportan de este modo y a las que se recurre con frecuencia.

Para el análisis de dos variables categóricas nos interesa estudiar cómo se distribuyen los casos según las combinaciones de categorías de cada variable. Por ejemplo, si disponemos de la variable angor y la variable tabaquismo, podemos estudiar cual es la distribución del tabaquismo en el grupo que presenta angor y en aquel que no lo presenta; para todo esto lo ideal es expresarlo mediante una tabla de contingencia donde nos da lo mismo qué variable ocupe las filas y cual las columnas si se trata de variables independientes; para el caso de las variables dependientes una de otra se suele colocar la variable independiente (ejemplo: factor de riesgo) en las filas y la dependiente en columnas.

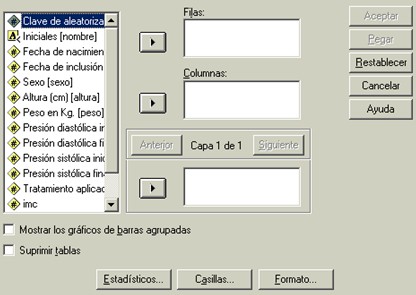

En SPSS construimos una tabla de contingencia mediante el procedimiento Analizarà Estadísticos descriptivosà Tablas de contingencia, con lo que llegamos a la siguiente ventana:

Vemos que las variables vuelven a quedar a la izquierda de la caja y que disponemos de dos ubicaciones, dos cajas en las que introducir la/s variables por filas o columnas según deseemos. Si queremos cruzar las variables de filas y columnas de acuerdo a alguna variable de agrupamiento introduciríamos esta última en la caja de "capas".

Siguiendo con nuestro fichero de ejemplo, podemos desear ver cuál es la distribución del grado de obesidad según el sexo. Obviamente habremos de transformar un dato cuantitativo continuo como es el índice de masa corporal (IMC) en una variable categórica (obeso/no obeso) para proceder a este análisis.

Actualmente se considera que según el índice de masa corporal (IMC) los pacientes pueden ser clasificados como obesos si tienen un índice de masa corporal (IMC) mayor de 29, por tanto puedo a partir de la variable índice de masa corporal (cuantitativa) recodificar a una variable nueva, llamada obesidad, en función de este punto de corte para el índice de masa corporal (IMC). Para ello seguir el procedimiento dictado en el apartado de "recodificación", teniendo en cuenta que índice de masa corporal (IMC) 0-29: no obesoà valor 0 y índice de masa corporal (IMC)>29 = obesoà valor 1.

Ahora quiero saber la distribución de la obesidad por sexos: Analizarà Estadísticos descriptivosà Tablas de contingencia

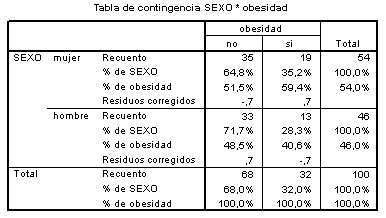

Tabla de contingencia obesidad – sexo.

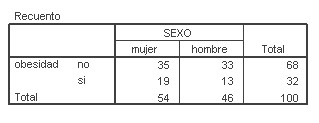

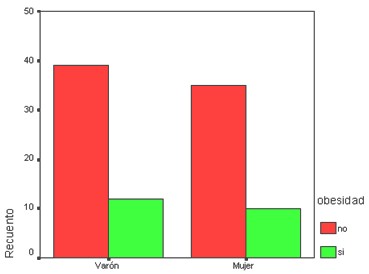

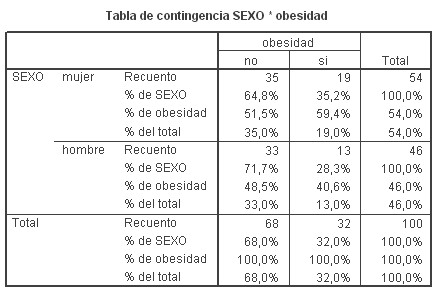

Vemos que se obtiene una tabla 2x2 donde queda claro cuántos varones son o no obesos y cuantas mujeres son o no obesas, según un sentido de lectura de la tabla. Disponemos de cifras totales por columnas, por filas y el total global. Además, puedo pedir al programa que muestre el gráfico asociado picando en la casilla "mostrar gráficos de barras agrupadas", con el siguiente resultado:

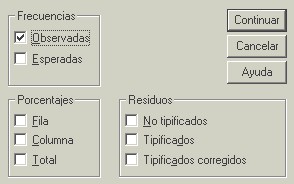

Las tablas de contingencia nos permiten obtener, aún antes de entrar en los estadísticos específicos, muchos más datos, veamos las opciones que se abren al picar en "casillas":

Podemos obtener las frecuencias de presentación las variables (observadas y esperadas sí se desea); el porcentaje de ocurrencia de los casos mostrado por filas, columnas y el total. Los residuales hacen referencia a la diferencia existente entre los valores observados y los esperados y pueden mostrarse bien de modo estándar (tipificados) o corregidos.

Picando en porcentajes por fila, columna y totales la tabla anterior queda ahora así:

1. ESTADISTICOS

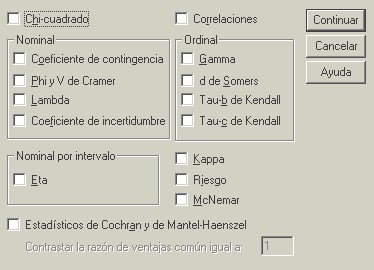

Una vez tenemos la tabla construida podemos empezar a entrever información pero no nos permite conocer si existe asociación entre las variables, para ello necesitaremos una prueba de significación, a la que se accede mediante el botón estadísticos, que da paso a esta pantalla:

Debemos hablar de asociación pero no de dependencia tras aplicar los estadísticos que veremos a continuación. Que exista asociación significa que dos hechos suceden juntos pero no necesariamente que un hecho dependa del otro de un modo directo. Generalmente cuando existe asociación, debajo suele existir algún elemento que relaciona ambos fenómenos aunque no puedo hablar de causalidad con este tipo de estudios. Más concretamente diremos que existe dependencia cuando ya somos capaces de decir que las variaciones de una de las variables quedan explicadas o provocadas por un segundo factor.

1.1 CHI CUADRADO DE PEARSON.

Es el estadístico más usual en este tipo de tablas y se utiliza para determinar si hay o no asociación entre dos variables de carácter categórico. El test se basa en la comparación de las frecuencias observadas con las esperadas para un determinado fenómeno; la relación matemática entre los cuadrados de las diferencias de las frecuencias observadas y esperadas proporciona un valor para un determinado nivel de confianza y para los grados de libertad correspondientes. Si el valor calculado supera el que proporciona de modo teórico el Ji cuadrado se rechaza Ho (hipótesis nula) y concluimos que existe una relación o asociación entre las variables. El test no informa de cuan intensa es la fuerza de la asociación y se puede ver afectado por varios factores externos y factores de confusión.

Para aplicar este test es conveniente que:

1. Los datos procedan de muestras aleatorias de una distribución multinomial.

2. Los valores esperados no sean muy pequeños. Se recomienda que, como mínimo, existan 5 casos en cada celda (en caso de que haya menos de 5 pero más de 3 habría que aplicar la corrección por continuidad de Yates).

Nota: Algunos autores recomiendan usar la corrección c. Yates siempre porque parece ser más sensible, de modo que si obtenemos significación tras aplicarla, es porque de no haberla usado también la habríamos obtenido. Cuando se comparan proporciones entre dos grupos independientes no hace falta calcularla, porque de ser el número de casos menor de 5 en una celda, SPSS calcula automáticamente la prueba exacta de Fisher. Tanto la corrección de Yates como la prueba de Fisher nos las da el programa de modo automático cuando trabajamos con una tabla de contingencia con dos variables dicotómicas.

Veamos cómo se presenta la tabla de contingencia entre las variables sexo y obesidad, variables ambas dicotómicas:

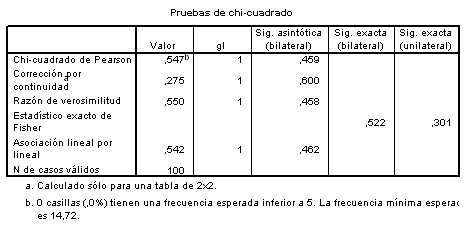

Obtenemos la tabla y hemos seleccionado las casillas de proporcionar % por filas y por columnas, con lo que aumenta el global de información obtenida. Bajo esta tabla, si hemos seleccionado "Chi cuadrado" aparece ya la siguiente con los resultados del estadístico y Chi y además el test de Fisher y Yates que nos vienen datos por defecto al ser variables dicotómicas como se mencionó antes.

Observando la tabla vemos que el 40.6% de los obesos son varones y el 59.4% de los obesos son mujeres. La cuestión es ¿ambos porcentajes son realmente distintos o la diferencia que observo se debe solo al azar? Para responder a esto deberíamos aplicar el estadístico Ji cuadrado.

Vemos que el Chi cuadrado proporciona una significación bilateral (dos colas) de 0.459 y como 0.459 > 0.05, entonces concluyo Ho, esto es, no existe asociación entre las variables sexo y obesidad. Además se calculó la corrección por continuidad y el exacto de Fisher, que de modo concordante, tampoco proporcionan significación estadística.

La razón de verosimilitud es un estadístico que también se distribuye según una chi cuadrado y que se aplica para el estudio de variables categóricas cuando hay modelos log-lineales.

1.2 MEDIDAS DE ASOCIACIÓN

El problema que plantea el test es que la significación puede variar en función del número de grados de libertad y del tamaño de la muestra (a mayor tamaño muestral, más probabilidad de obtener significación). Otros estadísticos, conocidos como Medidas de Asociación, se diseñaron con la idea de obtener índices que fueran de 0 a 1 y que nos permitieran cuantificar la asociación y comparar así muestras diferentes. En resumen, se trata de medidas que pretenden disminuir la influencia que sobre el test de Chi tiene el tamaño de la muestra.

1. MEDIDAS DE ASOCIACIÓN BASADAS EN EL CHI CUADRADO.

A. Coeficiente Phi

B. Coeficiente de Contingencia

C. V. de Kramer

2. MEDIDAS BASADAS EN LA REDUCCIÓN PROPORCIONAL DEL ERROR

A. Lambda de Goodman y Kruskal

B. Tau de Goodman y Kruskal

C. Coeficiente de concordancia o Kappa de Cohen.

COEFICIENTE PHI

En las tablas con dos v.a dicotómicas, toma valores entre 0 y 1. Si una variable tiene más de dos categorías puede tomar valores mayores de 1.

COEFICIENTE DE CONTINGENCIA

Toma valores entre 0 y 1, pero es difícil que llegue a 1. Un valor de 0 indica independencia y cercano a 1 indica asociación.

V. DE KRAMER

Nunca excede de 1. En las tablas 2x2 toma el mismo valor que Phi. K es el menor del número de filas y columnas.

LAMBDA DE GOODMAN Y KRUSKAL

Tiene en cuenta la frecuencia de la categoría modal ( la más frecuente). Da valores entre 0 y 1. Según considere la fila como v.a independiente o dependiente, puedo calcular a partir de ella dos coeficientes (la lambda y la tau). Si no se cual es la independiente o dependiente, usar la versión simétrica del test. Lambda toma valores entre 0 y 1, el valor 0 indica que la va independiente no aporta nada en la reducción del error de predicción y 1 indica que el error de predicción se ha conseguido reducir por completo.

TAU DE GOODMAN Y KRUSKAL

Tiene en cuenta las proporciones de los marginales para determinar las probabilidades dentro de cada celda. Va de 0 a 1 y se acompaña de un error asintótico luego puedo calcularle un intervalo de confianza. El significado de los valores 0 y 1 es el mismo que en lambda.

COEFICIENTE DE CONCORDANCIA O KAPPA DE COHEN

Se suele utilizar en los trabajos que pretenden evaluar el acuerdo entre dos observadores, por eso también se le llama "índice de acuerdo kappa". En resumen, dado un mismo fenómeno que es evaluado por dos observadores/jueces distintos, este estadístico me permite conocer la concordancia entre las aseveraciones de cada juez comparadas con las previsibles según el azar.

Toma valores entre 0 (mínima concordancia) y 1 (máxima). El programa da un error estándar (EE) que permite construir un intervalo de confianza (IC).

Valores que toma:

< 0.20: muy débil

0.21-0.40: débil

0.41-0.60: moderada

0.61-0.80: buena

0.81-1: muy buena

2 ESTIMACIÓN DE RIESGOS

En ocasiones las variables se comportan como factor de riesgo una y como variable de resultado de fenómeno la otra de tal modo que la presencia de la primera va determine la aparición del resultado con una mayor frecuencia, es precisamente en este caso cuando decimos que se está comportando como un factor de riesgo.

Veamos las medidas de que disponemos para estudiar riesgos:

1. RIESGO RELATIVO.

Se utiliza en los estudios de cohortes.

RR= IAe/IAo

IAe: incidencia en el grupo con el factor, expuesto

IAo: incidencia en el grupo sin el factor, no expuesto

El procedimiento de cálculo seria: AnalizaràEstadísticos descriptivosàTablas de contingenciaà EstadísticosàRiesgo.

Es importante saber que el programa calcula el RR interpretando que la primera columna es la enfermedad y proporciona el RR de padecer la "V.A" ubicada en la primera columna de la tabla 2x2. Este detalle es importante a la hora de construir la tabla y, por supuesto, en el momento de interpretar el riesgo.

Valores: >1 indica que se trata de un F. de riesgo. <1 que se comporta como factor protector.

2. ODDS RATIO

Se utiliza en los estudios de casos y controles.

OR = Odds en grupo casos / Odds en grupo controles

Para su cálculo, SPSS interpreta que los casos están en la primera fila y los controles en la segunda, así como que el factor de riesgo está en la primera columna y su ausencia en la segunda. La interpretación de sus valores es análoga al Riesgo Relativo. Si calculado el intervalo de confianza, el 1 estuviera incluido en él, nos indica que no existe significación.